Die Website steht. Sie ist gut aufgebaut, diverse SEO-Massnahmen sind umgesetzt, dennoch scheint Google die URL nicht zu kennen. Was ist passiert? Was können Sie tun?

Ob neue oder bestehende URL – treffen kann es theoretisch alle Websites im Netz: Weder Google noch diverse SEO-Tools zeigen gute Treffer. Nachfolgend gehen wir auf die wichtigsten Gründe ein und zeigen auch Tools, die bei der Fehlersuche und Fehlerbehebung helfen können.

Dieser Beitrag ist eine Fortsetzung von:

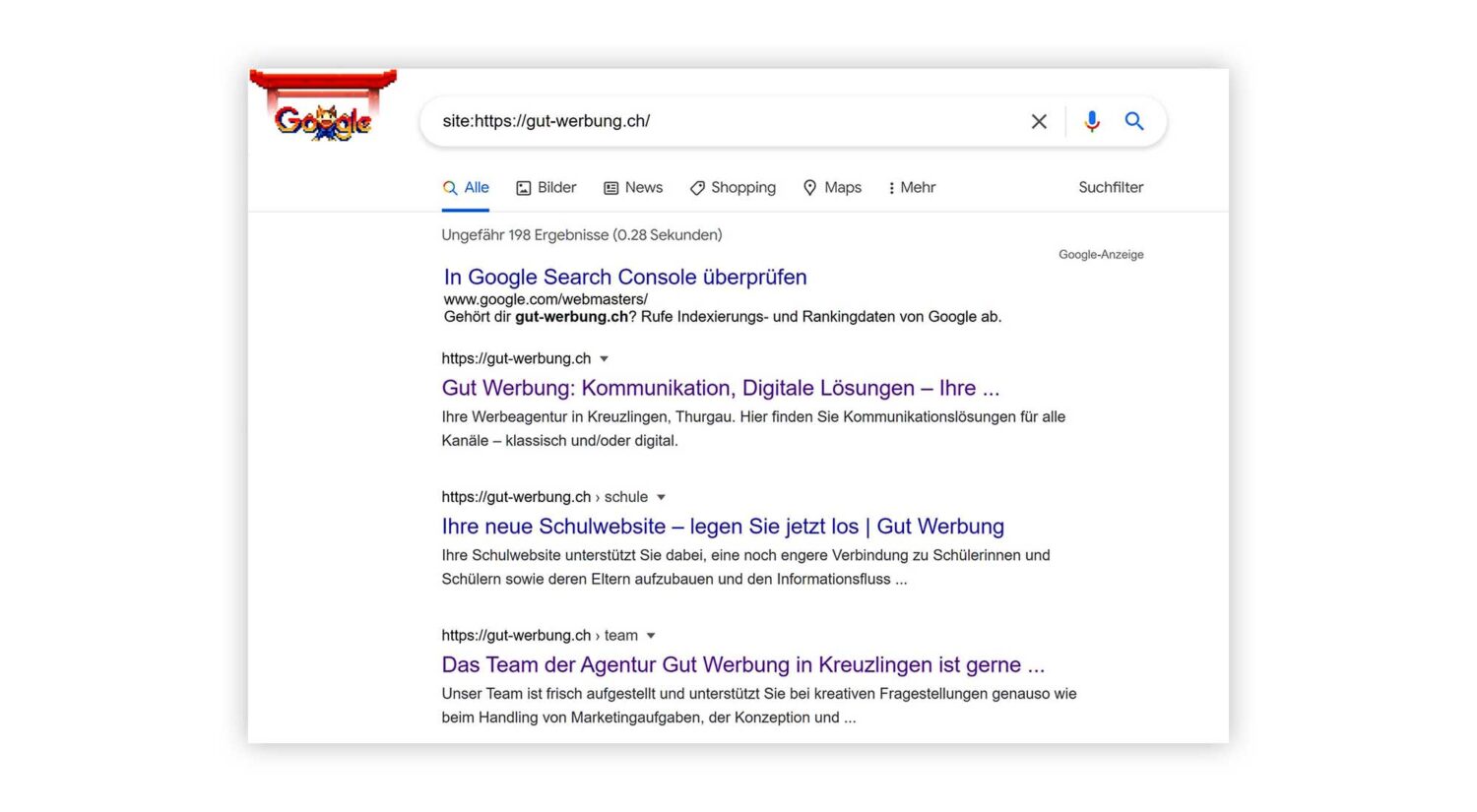

«Wie überprüfe ich, ob Google meine Website kennt?»

Dazu brauchen Sie nur Google und einen bestimmten Befehl.

- Kopieren Sie die URL, die Sie überprüfen möchten.

- Öffnen Sie Google im Browser Ihrer Wahl, tippen Sie ein: «site:» – unmittelbar gefolgt von Ihrer kopierten URL (ohne Leerzeichen zwischen Befehl und URL). Auf dem Bild unten sehen Sie, wie so eine Suchabfrage aussehen kann:

«Meine neue URL wird von Google nicht gefunden!»

Die Ursache Nummer eins dafür, dass Google eine neue URL nicht kennt: Google hat diese Seite noch nicht «entdeckt». Die Funktionsweise erklären wir übrigens ganz kurz im ersten Teil dieses Beitrags unter:

Und Google braucht definitiv Zeit, um eine neue URL zu finden und zu indexieren. Es können mehrere Wochen vergehen, bis eine neue Website vom Suchalgorithmus gefunden (gecrawlt) und gelistet (indexiert) wird. Idealerweise hat man als Betreiber der Website keine Stolperfallen eingebaut, die Google und andere Suchmaschinen am Crawling und Indexing hindern. Welche das sein können, zeigen wir im nächsten Abschnitt.

Jetzt aber wollen wir kurz aufzeigen, wie Sie Google vermitteln können, dass Ihre Brand-URL relevant und wichtig ist, um das Crawling und Indexing etwas zu beschleunigen:

- Sie reichen die neue URL über eine sogenannte XML-Sitemap ein.

- Sie verwenden das URL-Inspection-Tool der Google Search Console.

- Sie verlinken die neue URL intern von allen relevanten Seiten.

- Sie versuchen, Links zur neuen URL von vertrauenswürdigen externen Websites zu bekommen.

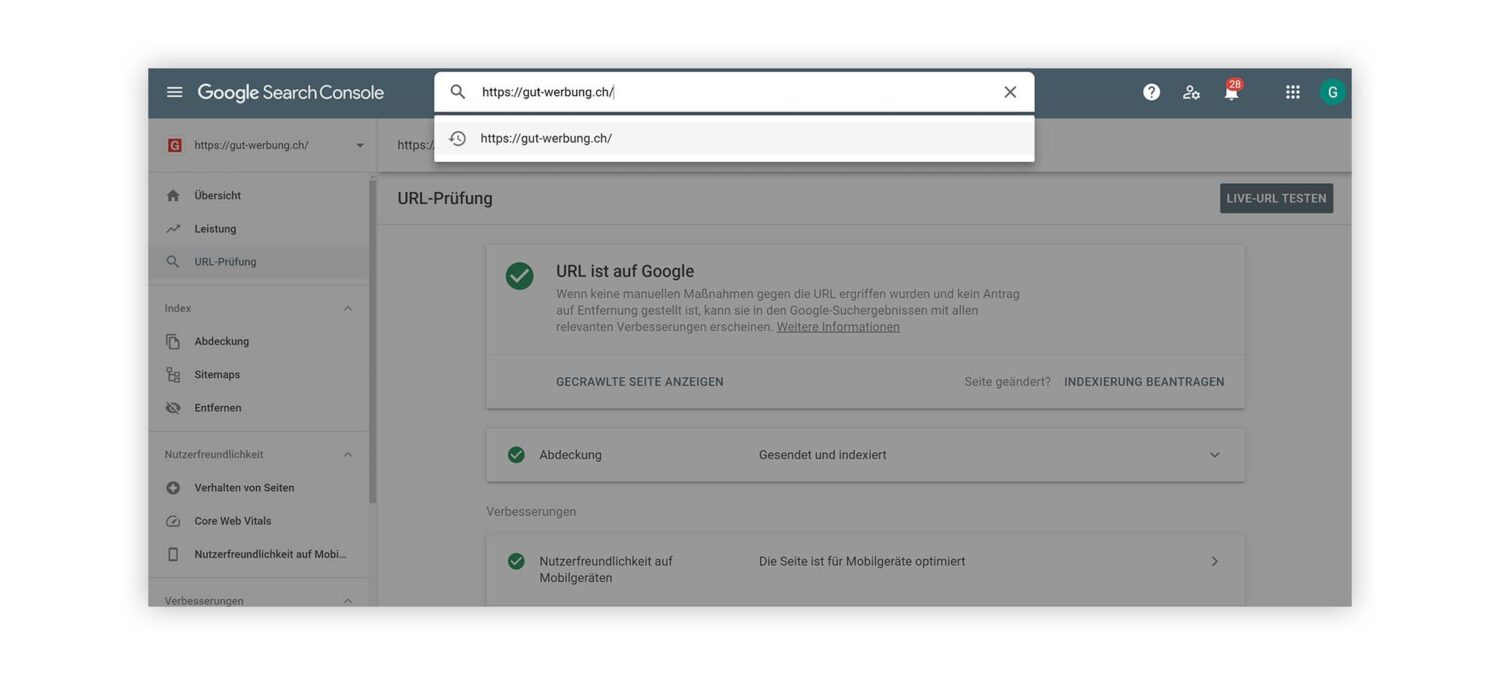

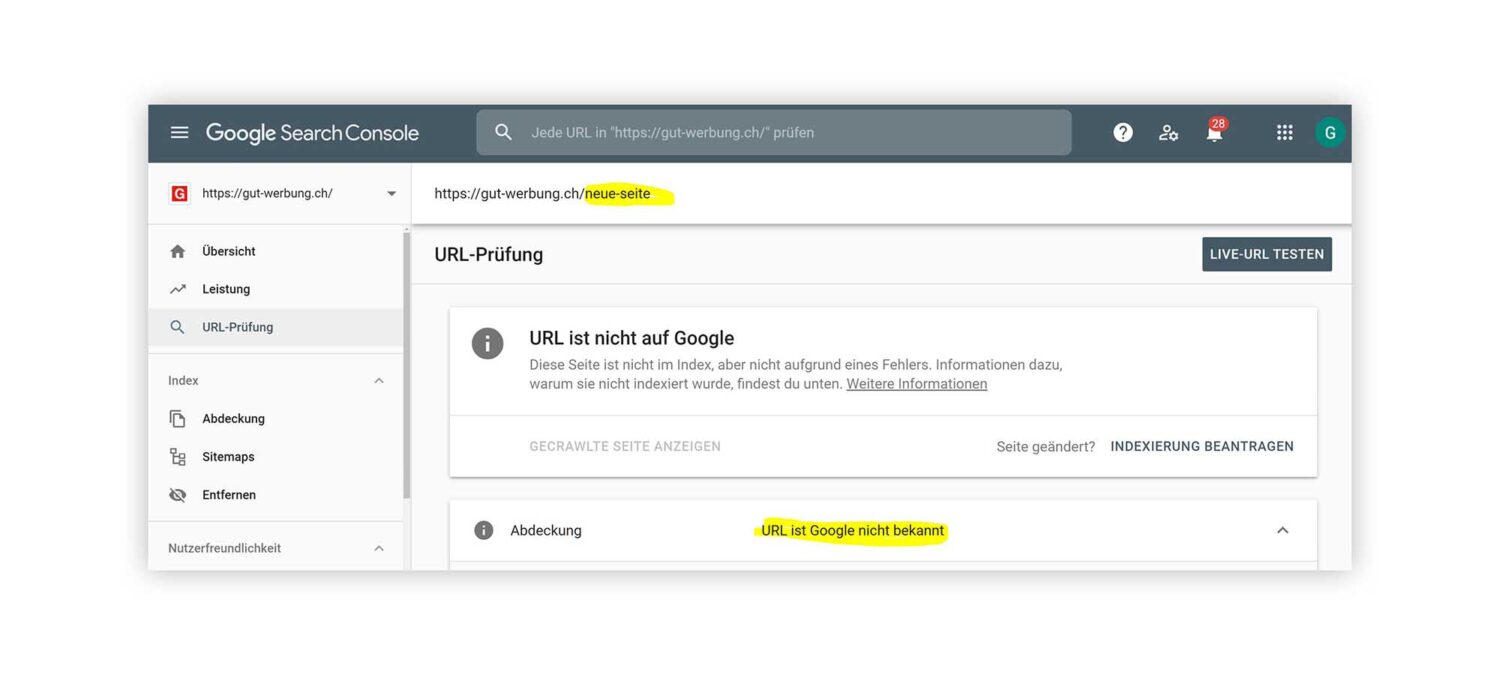

Die Google Search Console bietet Webmastern die Möglichkeit, den Suchgiganten auf neue URLs aufmerksam zu machen.

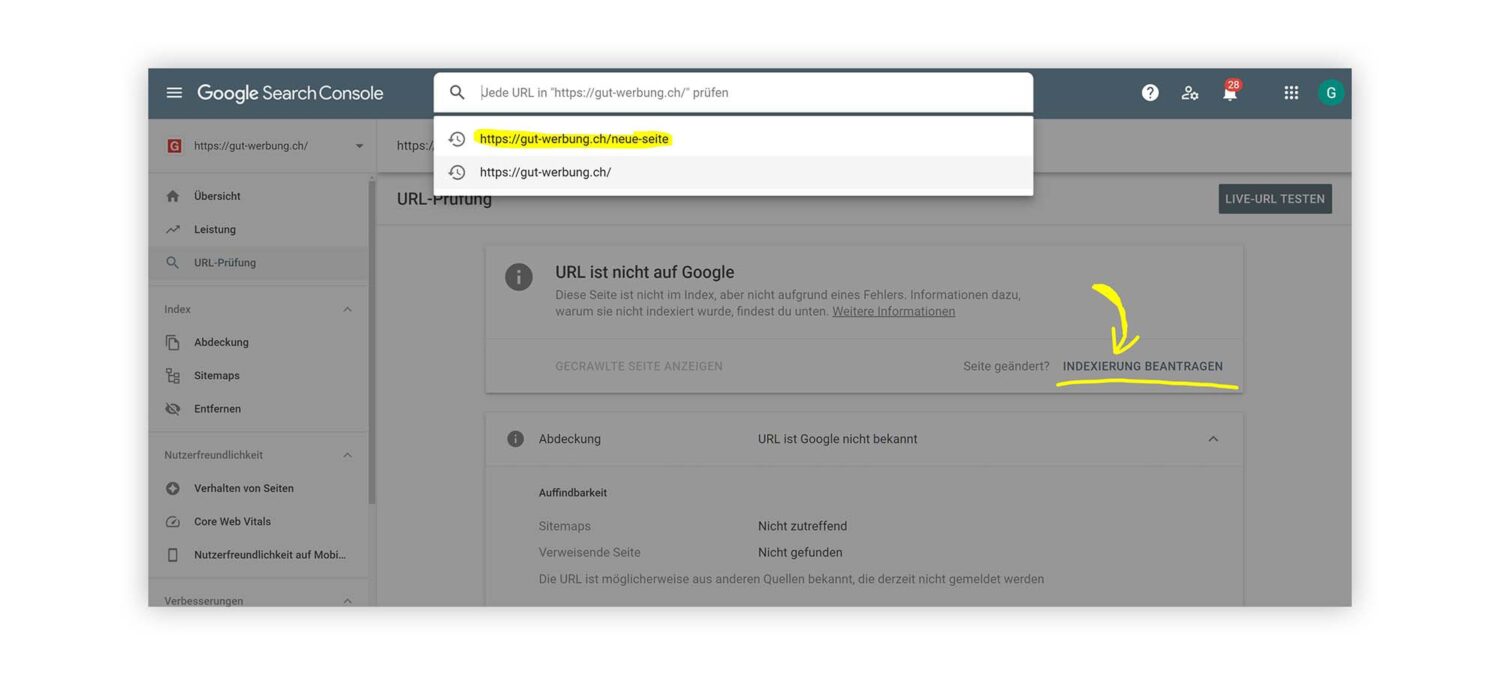

Dazu loggen Sie sich mit entsprechenden Rechten ein und rufen in der Search Console das sogenannte URL-Inspection-Tool auf. In der Abbildung unten zeigen wir, wie diese Oberfläche bedient wird: Ins obere Suchfenster geben Sie die neue URL ein, deren Crawling und Indexing Sie voranbringen möchten. Diese URL wird dann von Google analysiert.

Bei brandneuen URLs kommt die Meldung «URL ist nicht auf Google» und dass kein Fehler vorliegt – die URL ist schlicht unbekannt. Daneben erscheint der Befehl «Indexierung beantragen».

Mit einem Klick darauf starten Sie den wenige Minuten kurzen Prozess. Anschliessend warten Sie nur noch die Meldung der Search Console ab, dass Ihre URL zur Crawling-Warteschlange hinzugefügt wurde, fertig!

«Meine bestehende URL wird von Google nicht gefunden!»

Zu den typischen Gründen dafür gehören:

- Die Website unterdrückt die Indexierung der URL durch die Suchmaschine.

- Die Website sperrt die Crawler der Suchmaschine aus.

- Die URL weist Verlinkungsprobleme auf.

- Die Website beinhaltet sogenannten Duplicate Content und wird von Google «abgestraft».

- Die Crawler werden durch einen fehlerhaft gesetzten sogenannten «Canonical Tag» fehlgeleitet.

Fehlerquelle: Unterdrückte Indexierung

Mit dem noindex-Befehl kann man als Website-Betreiber Google daran hindern, seine Website zu indexieren. Das kann gute Gründe haben – oder aus Versehen passieren.

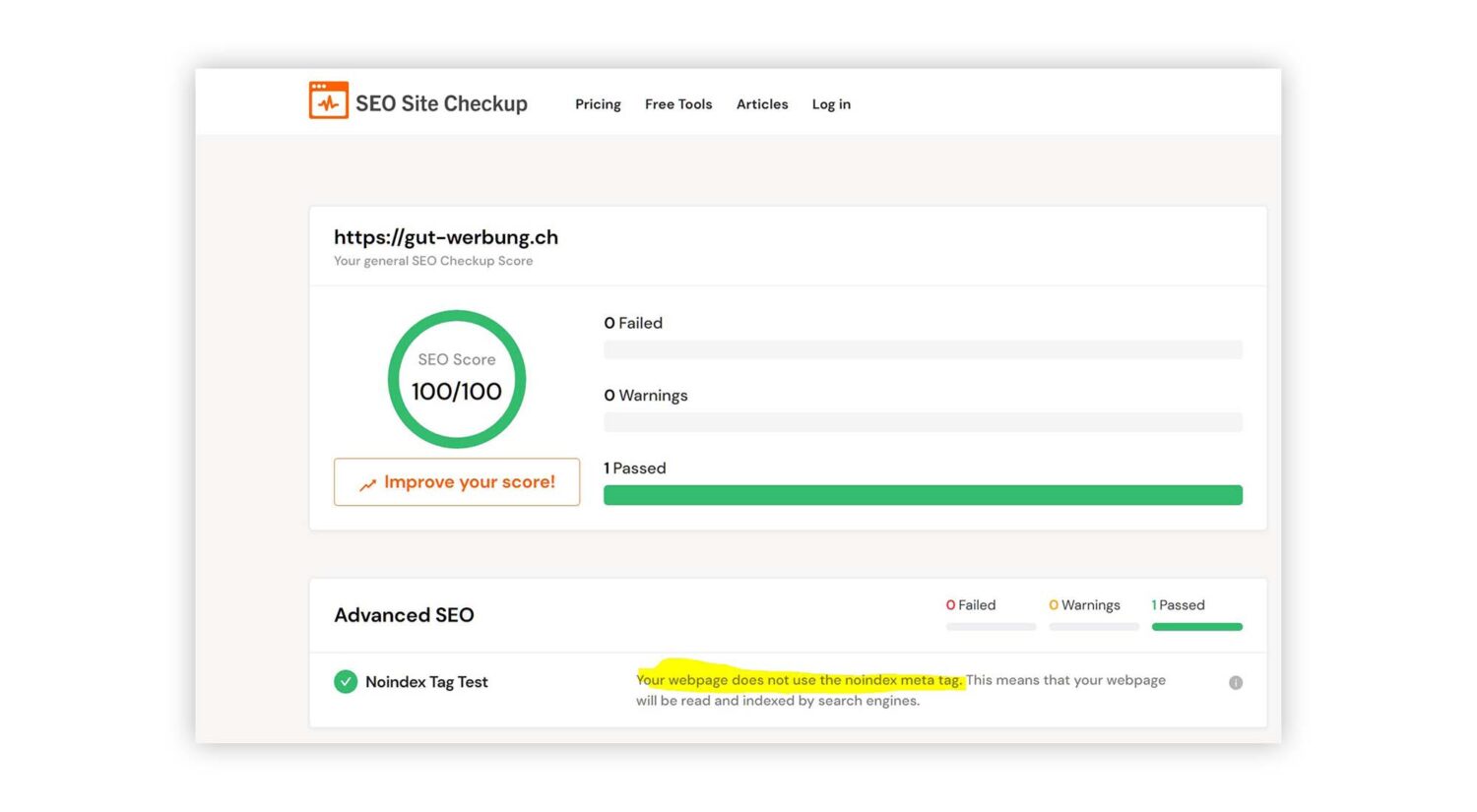

Um festzustellen, ob Ihre Website fälschlicherweise über den noindex-Befehl von der Indexierung durch die Suchmaschinen ausgenommen wurde, können Sie nutzen. Dieses Tool ist bei SEO-Massnahmen hilfreich; zeigt aber auch direkt an, ob die Seite auf «index» (grünes Licht zum Indexieren) oder «noindex» (Indexierung ausgesperrt) gesetzt wurde.

Fehlerquelle: Crawler? Nein, danke!

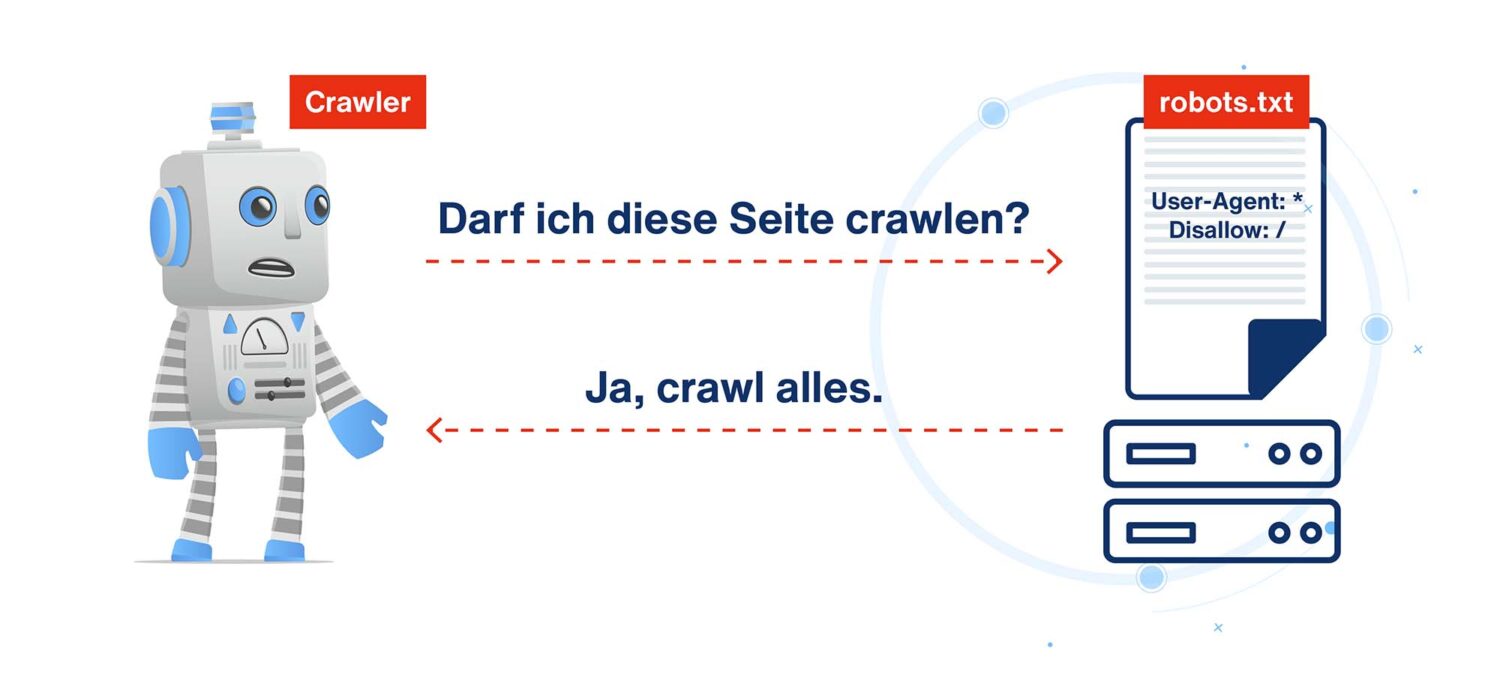

Website-Betreiber haben die Möglichkeit, den Crawlern der Suchmaschinen allgemein oder speziell den Crawlern von Google eine Art «Hausverbot» zu erteilen. Das ist sinnvoll für Unterseiten, die keine SEO-Relevanz haben, wie z. B. Error-404-Seiten, administrative Seiten, Warenkorb-Unterseiten oder Seiten mit Dankes- oder Statusmeldungen.

Um festzustellen, ob Sie Crawler unverrichteter Dinge davonjagen, schauen Sie im Rootverzeichnis Ihrer Domain nach. Auf das Rootverzeichnis greifen Sie ganz einfach zu, indem Sie hinter die URL ohne Leerzeichen folgenden Text eingeben:

/robots.txt

Sind Sie dort angekommen, schauen Sie bitte nach: Befindet sich dort eine Datei namens robots.txt, die folgenden Code beinhaltet?

User-Agent: *

Disallow: /

Wenn ja, sind Crawler ausgesperrt.

Und wenn der Inhalt in etwa wie folgt aussieht?

User-Agent: Googlebot

Disallow: /

Dann haben Sie «nur» Googles Crawler des virtuellen Hauses verwiesen, ups!

Sobald Sie die Disallow-Einträge löschen, dürfen die Crawler Ihre URLs ganz normal absuchen.

Steht am Zeilenanfang «User-agent: *», so ist dies ein Hinweis für Bots, die folgenden Befehle zu berücksichtigen, bis ein neuer User-agent-Befehl dies beendet. Das Sternchen (*; auch Fussnoten- oder Multiplikatorzeichen) ist dabei Platzhalter für alle Bots, damit eben auch alle Suchmaschinen-Bots erreicht werden.

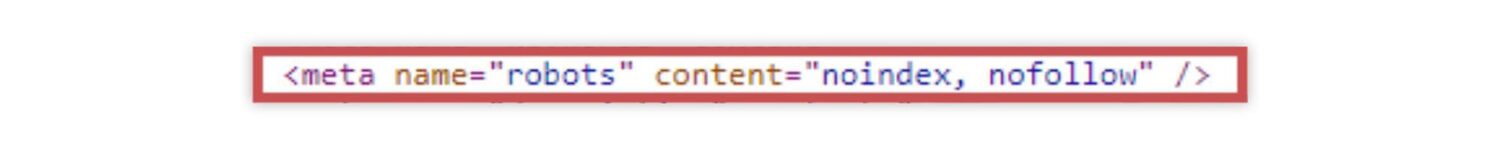

Fehlerquelle: nofollow-Links

Wenn Unterseiten oder Links mit «nofollow» markiert sind, sind sie für Crawler unsichtbar. Diese Markierung ist wichtig und etwa bei werblichen Linkplatzierungen vorgeschrieben. Wurde sie aber ohne diesen Grund gesetzt, verhindert sie die Sichtbarkeit für Crawler und somit für die Suchmaschine.

Halten Sie im Head-Bereich des Seitencodes nach diesem Tag Ausschau und entfernen Sie den «nofollow»-Wert:

Fehlerquelle: Duplicate Content

Ihn hier kann keine Suchmaschine leiden: Duplicate Content. Suchmaschinen lieben einzigartigen Content. Finden Crawler identische oder sehr ähnliche Inhalte, müssen sie anhand komplexer Algorithmen berechnen, welche der «Zwillingsseiten» relevanter und vertrauensvoller ist. Wer auch immer dabei nicht zur Nummer eins gezählt wird, wird einfach nicht gefunden – und nicht immer «gewinnt» der eigentliche Eigentümer des Textes!

Leider kann es im Eifer des Content-Gefechts passieren, dass eine Seite der anderen wie ein Ei dem anderen gleicht. Vielleicht hat man eine Produktbeschreibung des Herstellers eins zu eins für seinen Online-Shop übernommen. Vielleicht hat man einen Blogbeitrag eines Influencers komplett im eigenen Blog wiedergegeben.

Vermeiden Sie das, indem Sie Ihre Texte auf Plagiate überprüfen. Wenn Sie selbst Hersteller sind, empfiehlt es sich, Händlern geänderte Versionen Ihrer Produkttexte zur Verfügung zu stellen, die sich genügend von denen auf Ihrer Website unterscheiden.

Dabei hilft Ihnen für den Anfang der kostenlose Plagiatsprüfer https://smallseotools.com/de/plagiarism-checker/.

Fehlerquelle: Canonical Tag

Das HTML-Element «Canonical Tag» ist an sich eine clevere Sache. Damit sorgen Sie als Website-Betreiber dafür, dass mehrere URLs mit sehr ähnlichem oder sogar gleichem Inhalt bei der Indexierung einer Quell-URL zugewiesen werden. Mit diesem Trick umgehen Sie eine «Strafe» für Duplicate Content. Ein falsch gesetzter Canonical Tag (rel=canonical) verhindert allerdings die Indexierung einer Seite, bei der diese Massnahme nicht notwendig gewesen wäre.

Das Tool der Wahl hier ist wieder das URL-Inspection-Tool der Google Search Console. Geben Sie dort die nicht auffindbare URL ein und überprüfen Sie diese. Sagt Google nun «URL ist nicht bekannt», liegt ein Kanonisierungsfehler vor:

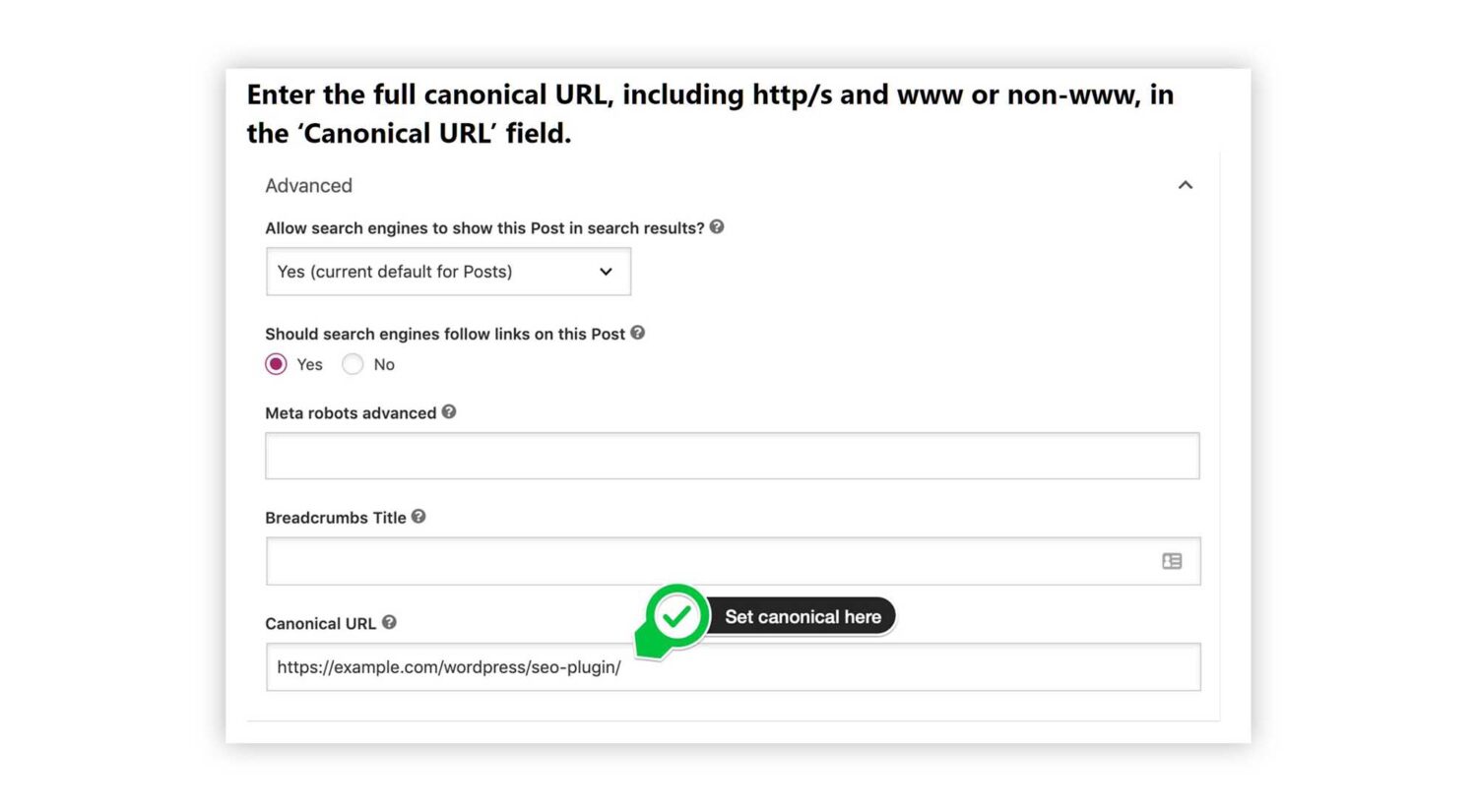

Dieser Fehler kann etwa dann passieren, wenn man im CMS den Tag falsch setzt oder den Code einer Unterseite samt Canonical Tag kopiert, ohne diesen zu entfernen. Ist die Kanonisierung falsch, loggen Sie sich zum Beheben des Fehlers in Ihr CMS, passen den Tag an und speichern Sie die Seite ab. Nachfolgend ein Beispiel einer entsprechenden WordPress-Bedienoberfläche über das SEO Plugin Yoast:

Anschliessend gehen Sie im URL-Inspection-Tool der Google Search Console die Schritte durch, die Sie für eine neue URL gehen würden (s. oben).

SEO-Audits – der Weg zum sauberen Suchergebnis

Es gibt natürlich noch einiges mehr an Fehlerquellen, die zu schlechten Suchergebnissen führen können, von «banalen» Broken Links bis hin zu Hackerangriffen. Aus diesem Grund empfehlen wir Unternehmen, regelmässige SEO-Audits durchzuführen. Diese gehören zu den SEO-Massnahmen und somit zum Online-Marketing unbedingt dazu, etwa wie ROI-Checks und KPI-Messungen.